La IA generativa se está convirtiendo en la base de más contenido, lo que hace que muchos se cuestionen la confiabilidad de su detector de IA.

En respuesta, se han realizado varios estudios sobre la eficacia de las herramientas de detección de IA para discernir entre el contenido humano y el generado por IA.

Desglosaremos estos estudios para ayudarlo a obtener más información sobre cómo funcionan los detectores de IA, mostrarle un ejemplo de detectores de IA en acción y ayudarlo a decidir si puede confiar en las herramientas o en los estudios.

¿Están sesgados los detectores de IA?

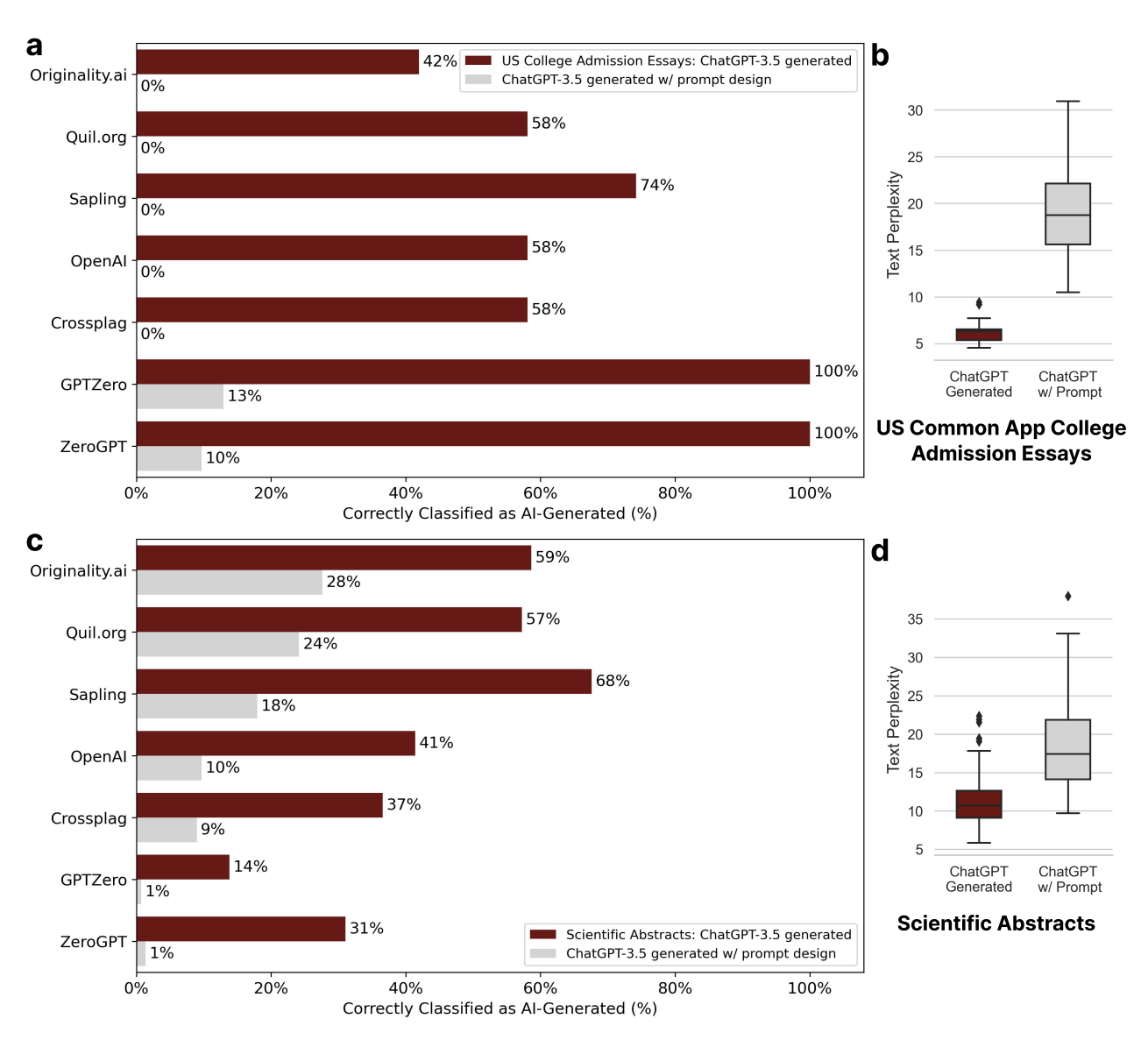

Los investigadores descubrieron que los detectores de contenido de IA, aquellos destinados a detectar contenido generado por GPT, podrían tener un sesgo significativo contra los escritores no nativos en inglés.

El estudio encontró que estos detectores, diseñados para diferenciar entre la IA y el contenido generado por humanos, clasifican erróneamente de manera constante las muestras de escritura en inglés no nativo como generadas por IA al tiempo que identifican con precisión las muestras de escritura en inglés nativo.

Usando muestras de escritura de escritores ingleses nativos y no nativos, los investigadores encontraron que los detectores clasificaron erróneamente más de la mitad de las últimas muestras como generadas por IA.

Curiosamente, el estudio también reveló que las estrategias de incitación simples, como “Elevar el texto proporcionado mediante el empleo de lenguaje literario”, podría mitigar este sesgo y eludir efectivamente los detectores GPT.

Captura de pantalla de Arxiv.org, julio de 2023

Captura de pantalla de Arxiv.org, julio de 2023Los hallazgos sugieren que los detectores de GPT pueden penalizar involuntariamente a los escritores con expresiones lingüísticas restringidas, lo que subraya la necesidad de un mayor enfoque en la imparcialidad y solidez dentro de estas herramientas.

Eso podría tener implicaciones significativas, particularmente en entornos evaluativos o educativos, donde los hablantes no nativos de inglés pueden ser penalizados o excluidos inadvertidamente del discurso global. De lo contrario, conduciría a “consecuencias injustas y al riesgo de exacerbar los sesgos existentes”.

Los investigadores también destacan la necesidad de realizar más investigaciones para abordar estos sesgos y perfeccionar los métodos de detección actuales para garantizar un panorama digital más equitativo y seguro para todos los usuarios.

¿Puedes vencer a un detector de IA?

En un estudio separado sobre texto generado por IA, los investigadores documentan la optimización de ejemplos en contexto (SICO) basada en sustitución, lo que permite que los modelos de lenguaje grandes (LLM) como ChatGPT evadan la detección de los detectores de texto generados por IA.

El estudio utilizó tres tareas para simular escenarios de uso de la vida real de LLM donde la detección de texto generado por IA es crucial, incluidos ensayos académicos, preguntas y respuestas abiertas y reseñas comerciales.

También implicó probar SICO contra seis detectores representativos, incluidos modelos basados en capacitación, métodos estadísticos y API, que superaron constantemente a otros métodos en todos los detectores y conjuntos de datos.

Los investigadores encontraron que SICO fue efectivo en todos los escenarios de uso probados. En muchos casos, el texto generado por SICO a menudo no se distinguía del texto escrito por humanos.

Sin embargo, también destacaron el posible mal uso de esta tecnología. Debido a que SICO puede ayudar al texto generado por IA a evadir la detección, los actores difamados también podrían usarlo para crear información engañosa o falsa que parezca escrita por humanos.

Ambos estudios apuntan a la velocidad a la que el desarrollo de IA generativa supera al de los detectores de texto de IA, y el segundo enfatiza la necesidad de una tecnología de detección más sofisticada.

Esos investigadores sugieren que la integración de SICO durante la fase de entrenamiento de los detectores de IA podría mejorar su robustez y que el concepto central de SICO podría aplicarse a varias tareas de generación de texto, abriendo nuevas vías para futuras investigaciones en generación de texto y aprendizaje en contexto.

¿Los detectores de IA se inclinan hacia la clasificación humana?

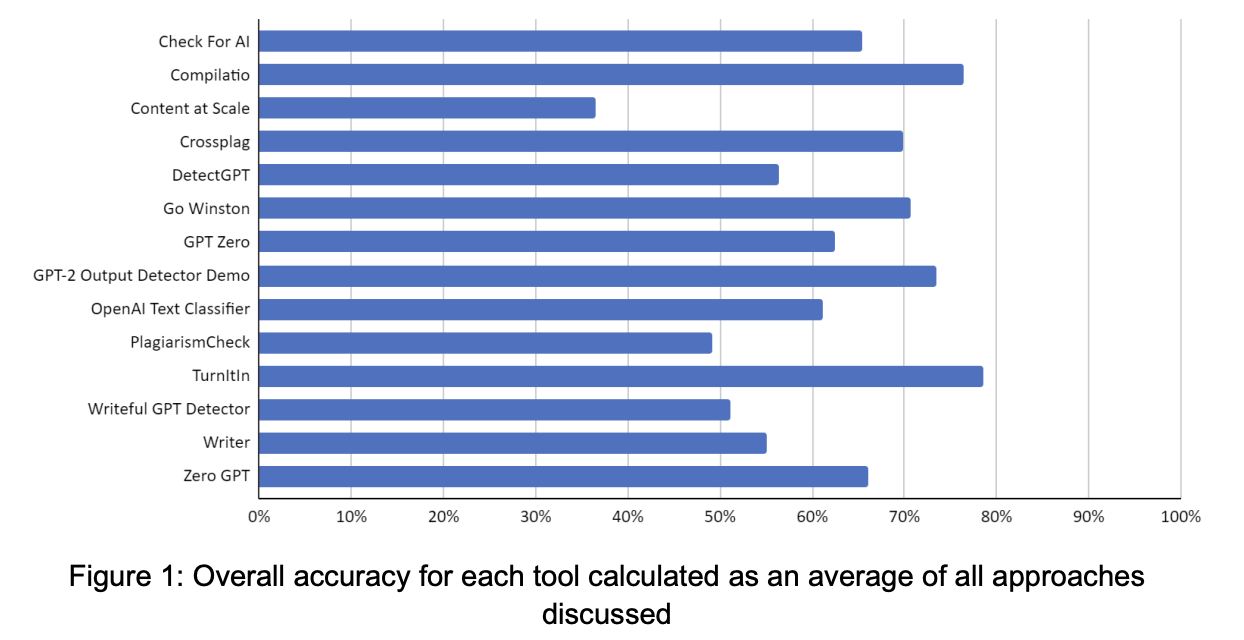

Los investigadores de un tercer estudio compilaron estudios previos sobre la confiabilidad de los detectores de IA, seguidos de sus datos, y publicaron varios hallazgos sobre estas herramientas.

- Aydin & Karaarslan (2022) revelaron que iThenticate, una popular herramienta de detección de plagio, encontró altas tasas de coincidencia con el texto parafraseado de ChatGPT.

- Wang et al. (2023) descubrió que es más difícil detectar el código generado por IA que el contenido en lenguaje natural. Además, algunas herramientas exhibieron sesgos, inclinándose hacia la identificación del texto como generado por IA o escrito por humanos.

- Pegoraro et al. (2023) descubrió que la detección de texto generado por ChatGPT es un gran desafío, y la herramienta más eficiente logra una tasa de éxito de menos del 50 %.

- Van Oijen (2023) reveló que la precisión general de las herramientas en la detección de texto generado por IA fue de solo alrededor del 28 %, y la mejor herramienta logró solo el 50 % de precisión. Por el contrario, estas herramientas fueron más efectivas (alrededor del 83 % de precisión) en la detección de contenido escrito por humanos.

- anderson et al. (2023) observaron que la paráfrasis reducía notablemente la eficacia del detector de salida GPT-2.

Usando 14 herramientas de detección de texto generadas por IA, los investigadores crearon varias docenas de casos de prueba en diferentes categorías, que incluyen:

- Texto escrito por humanos.

- Texto traducido.

- Texto generado por IA.

- Texto generado por IA con ediciones humanas.

- Texto generado por IA con paráfrasis de IA.

Estas pruebas se evaluaron utilizando lo siguiente:

Captura de pantalla de Arxiv.org, julio de 2023

Captura de pantalla de Arxiv.org, julio de 2023Turnitin surgió como la herramienta más precisa en todos los enfoques, seguida de Compilatio y GPT-2 Output Detector.

Sin embargo, la mayoría de las herramientas probadas mostraron un sesgo hacia la clasificación precisa del texto escrito por humanos, en comparación con el texto modificado o generado por IA.

Si bien ese resultado es deseable en contextos académicos, el estudio y otros destacaron el riesgo de acusaciones falsas y casos no detectados. Los falsos positivos fueron mínimos en la mayoría de las herramientas, excepto en GPT Zero, que exhibió una tasa alta.

Los casos no detectados fueron una preocupación, particularmente para los textos generados por IA que se sometieron a edición humana o paráfrasis automática. La mayoría de las herramientas tuvieron problemas para detectar dicho contenido, lo que representa una amenaza potencial para la integridad académica y la equidad entre los estudiantes.

La evaluación también reveló dificultades técnicas con las herramientas.

Algunos experimentaron errores de servidor o tuvieron limitaciones para aceptar ciertos tipos de entrada, como código de computadora. Otros encontraron problemas de cálculo y el manejo de los resultados en algunas herramientas resultó ser un desafío.

Los investigadores sugirieron que abordar estas limitaciones será crucial para implementar de manera efectiva herramientas de detección de texto generadas por IA en entornos educativos, asegurando la detección precisa de mala conducta y minimizando las acusaciones falsas y los casos no detectados.

¿Qué tan precisos son estos estudios?

¿Debería confiar en las herramientas de detección de IA basadas en los resultados de estos estudios?

La pregunta más importante podría ser si debe confiar en estos estudios sobre las herramientas de detección de IA.

Envié el tercer estudio mencionado anteriormente a jonathan guillham, fundador de Originality.ai. Hizo algunos comentarios muy detallados y perspicaces.

Para empezar, Originality.ai no estaba destinado al sector educativo. Es posible que otros detectores de IA probados tampoco hayan sido creados para ese entorno.

El requisito para su uso dentro de la academia es que produzca una respuesta exigible. Esto es parte de por qué comunicamos explícitamente (en la parte superior de nuestra página de inicio) que nuestra herramienta es para marketing digital y NO para la academia.

La capacidad de evaluar varios artículos presentados por el mismo escritor (no un estudiante) y emitir un juicio informado es un caso de uso mucho mejor que tomar decisiones consecuentes en un solo artículo presentado por un estudiante.

La definición de contenido generado por IA puede variar entre lo que indica el estudio y lo que identifica cada herramienta de detección de IA. Gillham incluyó lo siguiente como referencia a varios significados de IA y contenido generado por humanos.

- Generado por IA y no editado = Texto generado por IA.

- Generado por IA y editado por humanos = texto generado por IA.

- Esquema de IA, escrito por humanos y muy editado por IA = texto generado por IA.

- Investigación de IA y escrito humano = original generado por humanos.

- Escrito por humanos y editado con Grammarly = original generado por humanos.

- Escrito por humanos y editado por humanos = Original generado por humanos.

Algunas categorías en el estudio probaron texto traducido por IA, esperando que se clasificara como humano. Por ejemplo, en la página 10 del estudio, dice:

Para la segunda categoría (llamada 02-MT), se escribieron alrededor de 10.000 caracteres (incluyendo espacios) en bosnio, checo, alemán, letón, eslovaco, español y sueco. Ninguno de estos textos puede haber estado expuesto a Internet antes, como en el caso de 01-Hum. Según el idioma, se utilizó la herramienta de traducción de IA DeepL (3 casos) o Google Translate (6 casos) para producir los documentos de prueba en inglés.

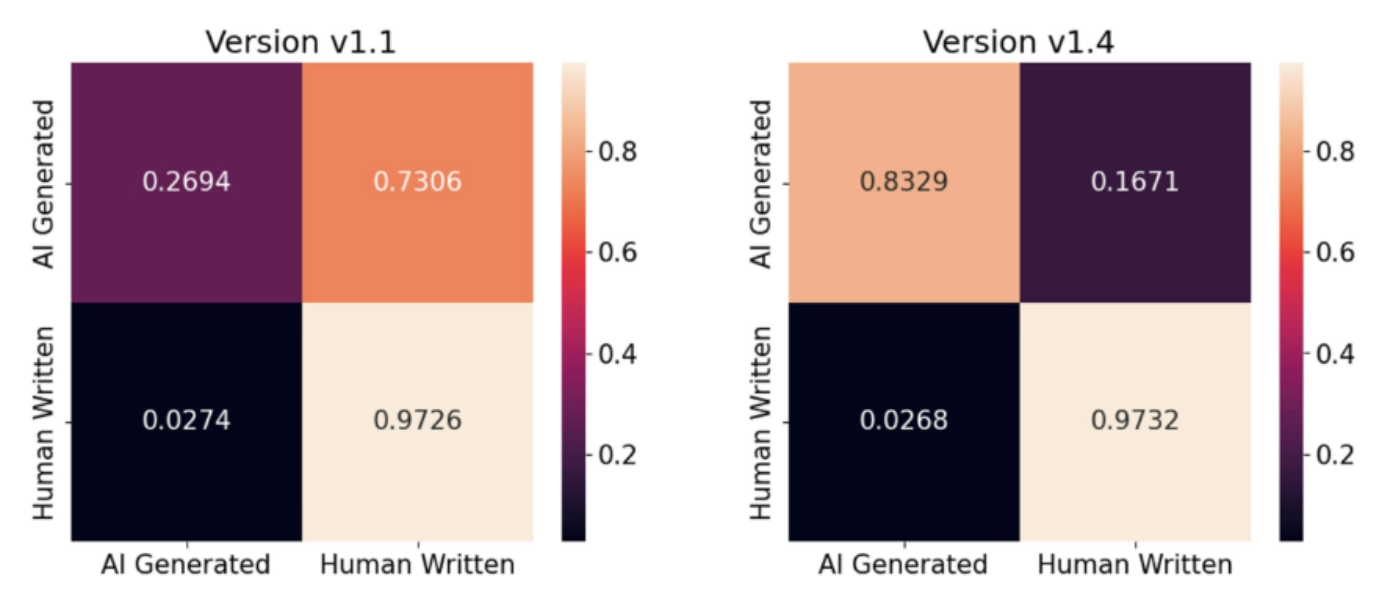

Durante el período de experimentación de dos meses, algunas herramientas habrían hecho grandes avances. Gillham incluyó una representación gráfica de las mejoras dentro de los dos meses posteriores a las actualizaciones de la versión.

Captura de pantalla de Originality.ai, julio de 2023

Captura de pantalla de Originality.ai, julio de 2023Los problemas adicionales con el análisis del estudio que identificó Gillham incluyeron un tamaño de muestra pequeño (54), respuestas clasificadas incorrectamente y la inclusión de solo dos herramientas pagas.

Los datos y los materiales de prueba deberían haber estado disponibles en la URL incluida al final del estudio. Una solicitud de datos realizada durante dos semanas sigue sin respuesta.

Lo que dijeron los expertos en IA sobre las herramientas de detección de IA

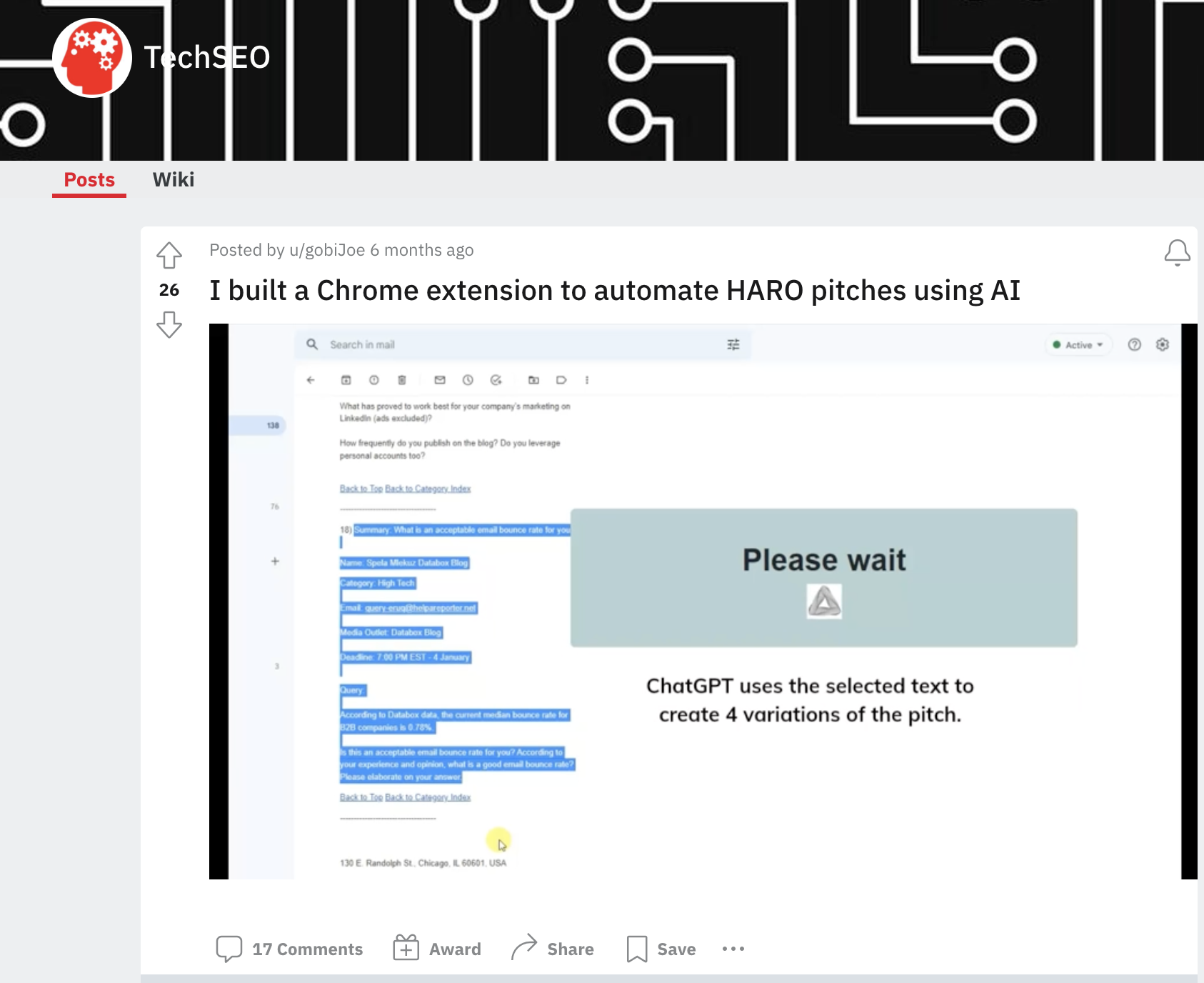

Consulté a la comunidad de HARO para averiguar qué tenían que decir otros sobre su experiencia con los detectores de IA, lo que llevó a un estudio propio no intencional.

En un momento, recibí cinco respuestas en dos minutos que eran respuestas duplicadas de diferentes fuentes, lo que parecía sospechoso.

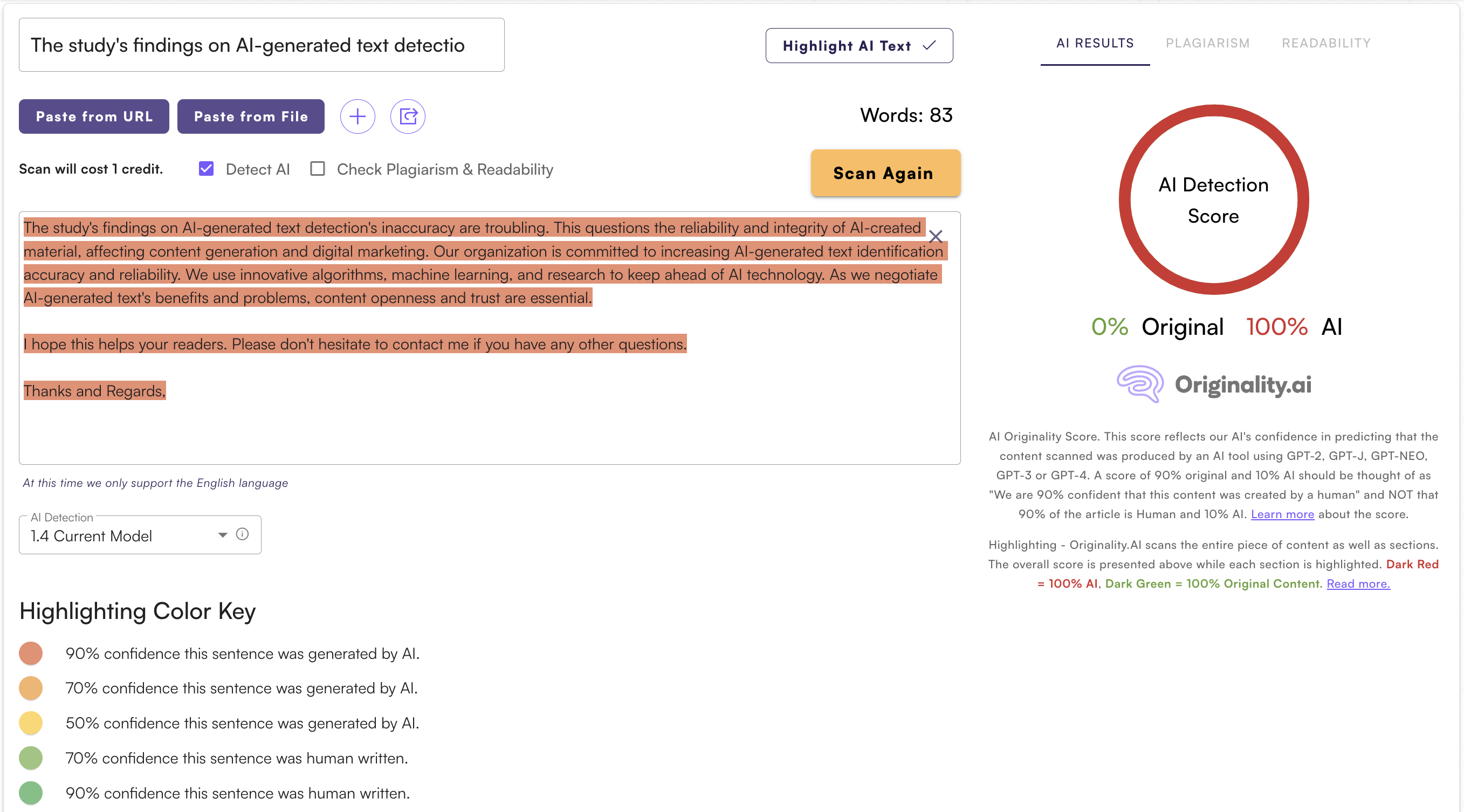

Decidí usar Originality.ai en todas las respuestas de HARO que recibí para esta consulta. Según mi experiencia personal y pruebas no científicas, esta herramienta en particular parecía difícil de superar.

Captura de pantalla de Originality.ai, julio de 2023

Captura de pantalla de Originality.ai, julio de 2023Originality.ai detectó, con un 100 % de confianza, que la mayoría de estas respuestas fueron generadas por IA.

Las únicas respuestas de HARO que resultaron principalmente generadas por humanos fueron introducciones de una o dos oraciones a fuentes potenciales que podría estar interesado en entrevistar.

Esos resultados no fueron una sorpresa porque hay extensiones de Chrome para ChatGPT para escribir respuestas HARO.

Captura de pantalla de Reddit, julio de 2023

Captura de pantalla de Reddit, julio de 2023Lo que dijo la FTC sobre las herramientas de detección de IA

La Comisión Federal de Comercio advirtió a las empresas que no sobrestimen las capacidades de las herramientas de IA para detectar contenido generado, advirtiendo que las afirmaciones de marketing inexactas podrían violar las leyes de protección al consumidor.

También se aconsejó a los consumidores que se mostraran escépticos ante las afirmaciones de que las herramientas de detección de IA pueden identificar de manera confiable todo el contenido artificial, ya que la tecnología tiene limitaciones.

La FTC dijo que se necesita una evaluación sólida para corroborar las afirmaciones de marketing sobre las herramientas de detección de IA.

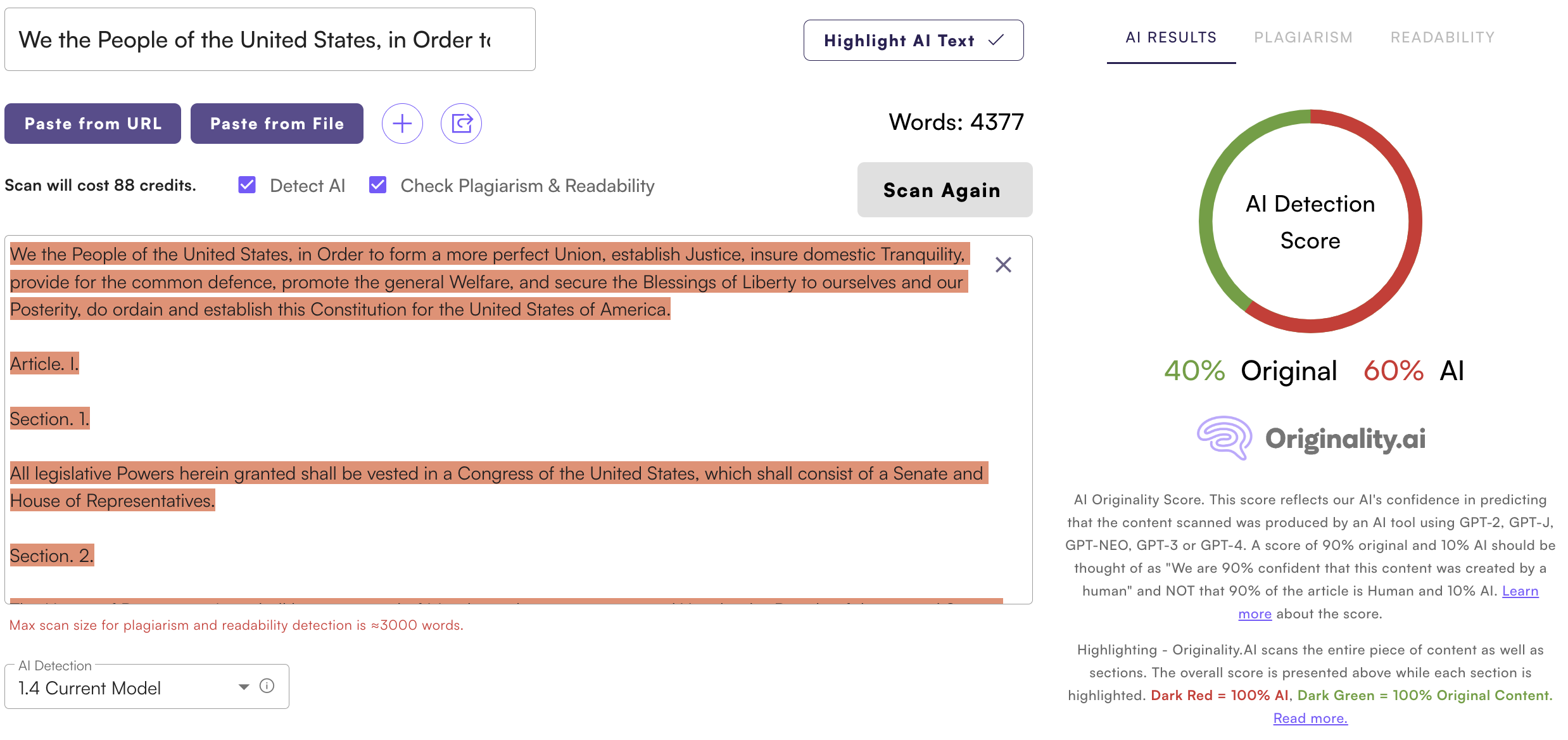

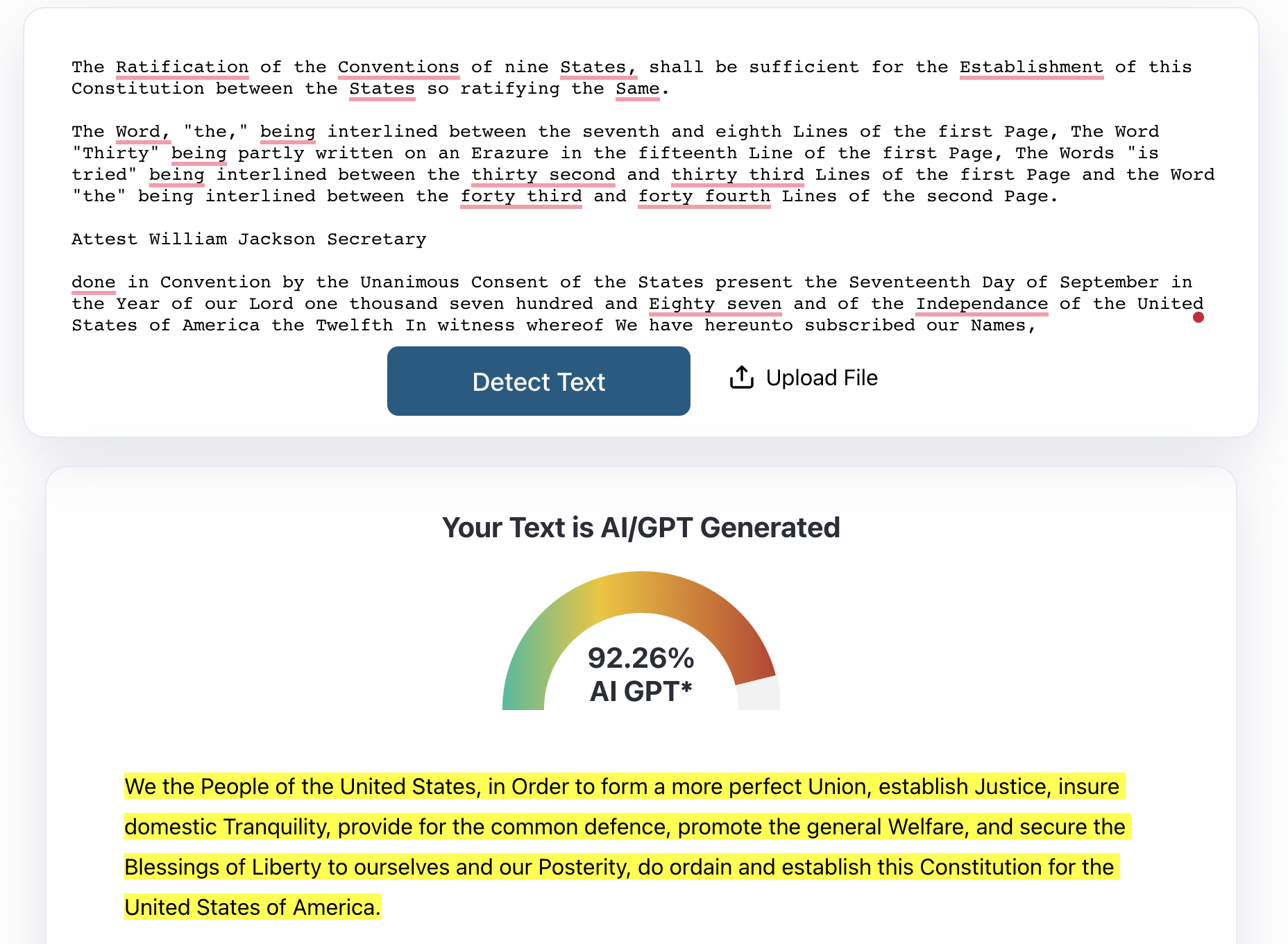

¿Se utilizó la IA para redactar la Constitución?

Las herramientas de detección de IA llegaron a los titulares cuando los usuarios descubrieron que existía la posibilidad de que la IA escribiera la Constitución de los Estados Unidos.

Captura de pantalla de Originality.ai, julio de 2023

Captura de pantalla de Originality.ai, julio de 2023Una publicación en Ars Technica explicó por qué las herramientas de detección de escritura de IA a menudo identifican falsamente textos como la Constitución de los EE. UU. como generados por IA.

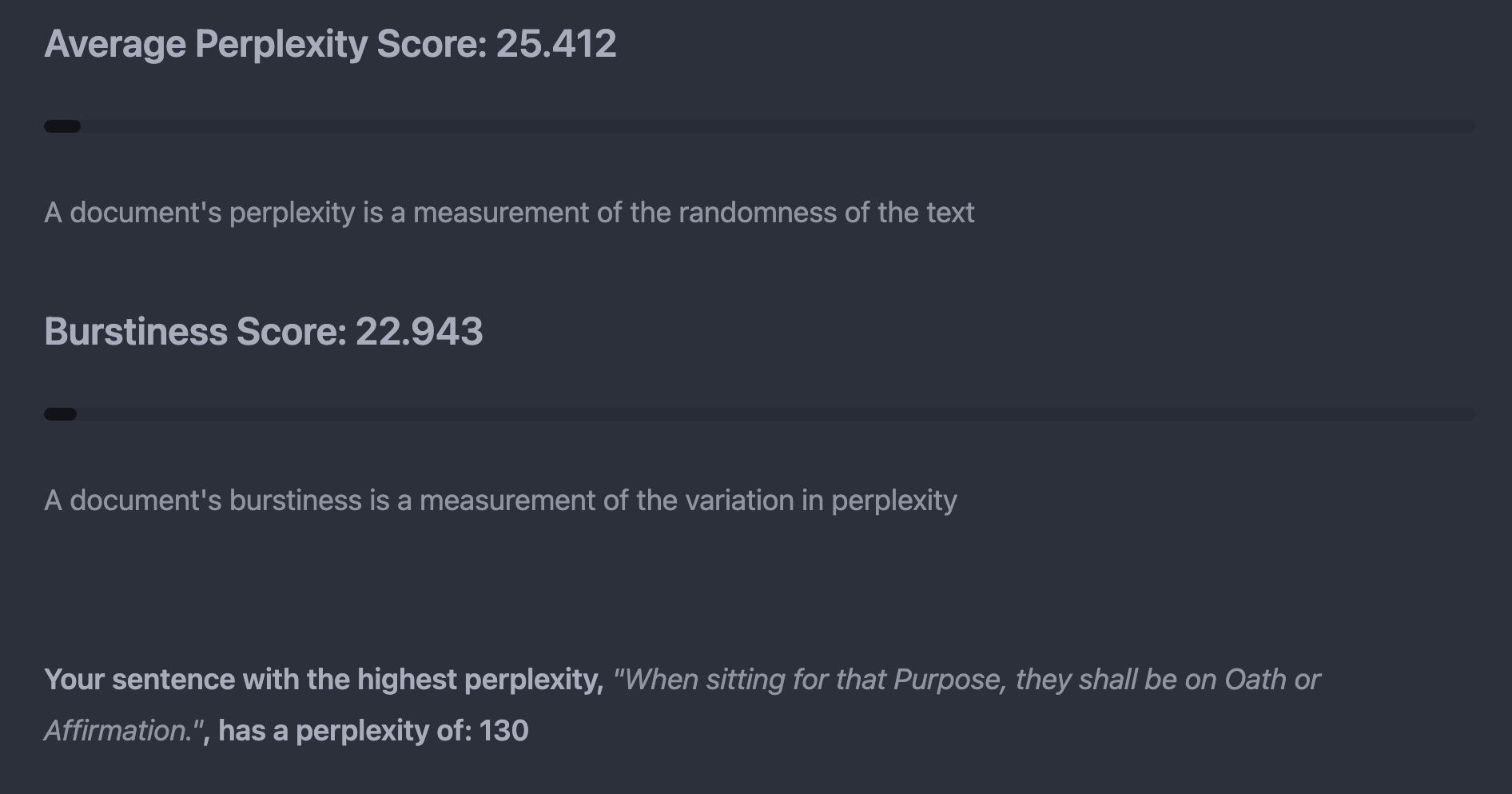

Captura de pantalla de ZeroGPT, julio de 2023

Captura de pantalla de ZeroGPT, julio de 2023El lenguaje histórico y formal a menudo otorga puntajes bajos de “perplejidad” y “explosión”, que interpretan como indicadores de escritura de IA.

Captura de pantalla de GPTZero, julio de 2023

Captura de pantalla de GPTZero, julio de 2023Los escritores humanos pueden usar frases comunes y estilos formales, lo que da como resultado puntuaciones similares.

Este ejercicio demostró aún más el punto de la FTC de que los consumidores deben ser escépticos con respecto a los puntajes de los detectores de IA.

Fortalezas y limitaciones

Los hallazgos de varios estudios destacan las fortalezas y limitaciones de las herramientas de detección de IA.

Si bien los detectores de IA han mostrado cierta precisión en la detección de texto generado por IA, también han mostrado sesgos, problemas de usabilidad y vulnerabilidades a las técnicas de evasión.

Pero los estudios en sí mismos podrían tener fallas, dejando todo en la especulación.

Se necesitan mejoras para abordar los sesgos, mejorar la solidez y garantizar una detección precisa en diferentes contextos.

La investigación y el desarrollo continuos son cruciales para fomentar la confianza en los detectores de IA y crear un panorama digital más equitativo y seguro.

Imagen destacada: Ascannio/Shutterstock