Inflection AI, los creadores del asistente personal PI AI, anunciaron la creación de un nuevo y poderoso modelo de lenguaje grande llamado Inflection-2 que supera al modelo de lenguaje PaLM de Google en una variedad de conjuntos de datos de evaluación comparativa.

Asistente personal Pi

Pi es un asistente personal que está disponible en la web y como aplicación para dispositivos móviles Android y Apple.

También se puede agregar como contacto en WhatsApp y acceder a través de mensajes directos de Facebook e Instagram.

Pi está diseñado para ser un asistente de chatbot que puede responder preguntas, investigar cualquier cosa, desde productos, ciencia o productos, y puede funcionar como un compañero de discusión que brinda consejos.

El nuevo LLM se incorporará a PI AI poco después de someterse a pruebas de seguridad.

Modelo de lenguaje grande Inflexión-2

Inflection-2 es un modelo de lenguaje grande que supera al modelo PaLM 2 Large de Google, que actualmente es el modelo más sofisticado de Google.

Inflection-2 se probó en múltiples puntos de referencia y se comparó con PaLM 2 y LLaMA 2 de Meta y otros modelos de lenguajes grandes (LLM).

Por ejemplo, PaLM 2 de Google apenas superó a Inflexión-2 en el corpus de Preguntas Naturales, un conjunto de datos de preguntas del mundo real.

PaLM 2 obtuvo una puntuación de 37,5 e Inflection-2 obtuvo una puntuación de 37,3, y ambos superaron a LLaMA 2, que obtuvo una puntuación de 33,0.

MMLU: comprensión masiva del lenguaje multitarea

Inflection AI publicó las puntuaciones de evaluación comparativa en el conjunto de datos MMLU, que está diseñado para probar los LLM de una manera similar a las pruebas en humanos.

La prueba abarca 57 materias en STEM (Ciencia, Tecnología, Ingeniería y Matemáticas) y una amplia gama de otras materias como derecho.

El propósito del conjunto de datos es identificar dónde el LLM es más fuerte y dónde es débil.

Según el trabajo de investigación para este conjunto de datos de evaluación comparativa:

“Proponemos una nueva prueba para medir la precisión multitarea de un modelo de texto.

La prueba cubre 57 tareas que incluyen matemáticas elementales, historia de Estados Unidos, informática, derecho y más.

Para lograr una alta precisión en esta prueba, los modelos deben poseer un amplio conocimiento del mundo y capacidad para resolver problemas.

Descubrimos que, si bien los modelos más recientes tienen una precisión casi aleatoria, el modelo GPT-3 más grande mejora la probabilidad aleatoria en casi 20 puntos porcentuales en promedio.

Sin embargo, en cada una de las 57 tareas, los mejores modelos aún necesitan mejoras sustanciales antes de que puedan alcanzar una precisión de nivel experto.

Los modelos también tienen un rendimiento desequilibrado y con frecuencia no saben cuándo están equivocados.

Peor aún, todavía tienen una precisión casi aleatoria en algunos temas socialmente importantes como la moralidad y el derecho.

Al evaluar exhaustivamente la amplitud y profundidad de la comprensión académica y profesional de un modelo, nuestra prueba se puede utilizar para analizar modelos en muchas tareas e identificar deficiencias importantes”.

Estas son las puntuaciones del conjunto de datos de evaluación comparativa de MMLU en orden de más débil a más fuerte:

- Llama 270b 68,9

- GPT-3.5 70.0

- Grok-1 73.0

- PaLM-2 Grande 78,3

- Claude-2 _CoT 78.5

- Inflexión-2 79,6

- GPT-4 86,4

Como se puede ver arriba, solo GPT-4 obtiene puntuaciones más altas que Inflexión-2.

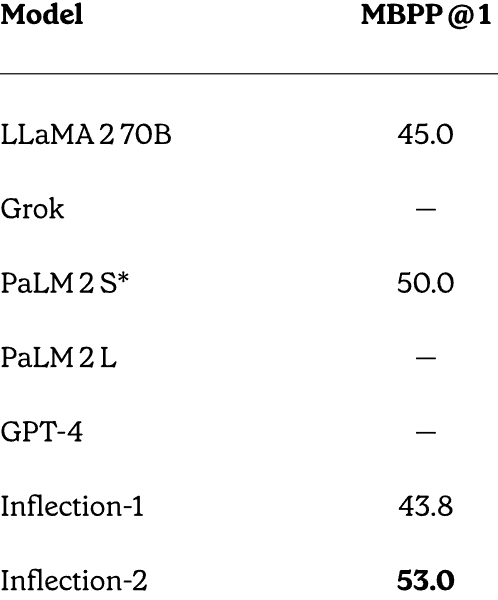

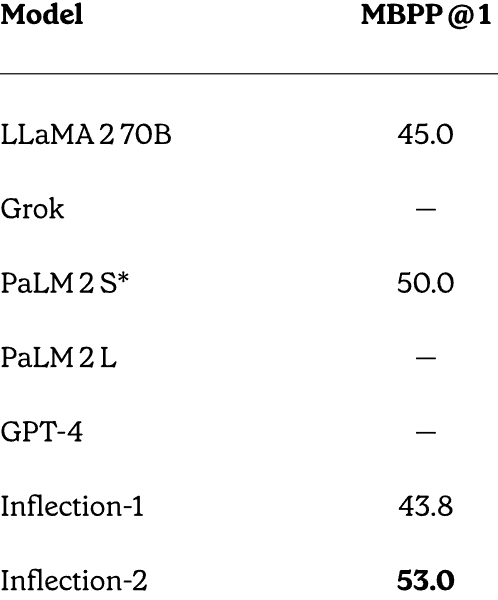

MBPP: rendimiento del razonamiento matemático y de código

Inflection AI realizó una comparación directa entre GPT-4, PaLM 2, LLaMA e Inflection-2 en pruebas de razonamiento matemático y de código y obtuvo resultados sorprendentemente buenos considerando que no estaba específicamente entrenado para resolver problemas matemáticos.

El conjunto de datos de evaluación comparativa utilizado se llama MBPP (Programación Python principalmente básica). Este conjunto de datos consta de más de 1000 problemas de programación Python de origen público.

Lo que hace que las puntuaciones sean especialmente notables es que Inflection AI se probó con PaLM-2S, que es una variante del modelo de lenguaje grande que se ajustó específicamente para la codificación.

Puntuaciones del MBPP:

- LLaMA-2 70B: 45.0

- PaLM-2S: 50.0

- Inflexión-2: 53.0

Captura de pantalla de puntuaciones completas de MBPP

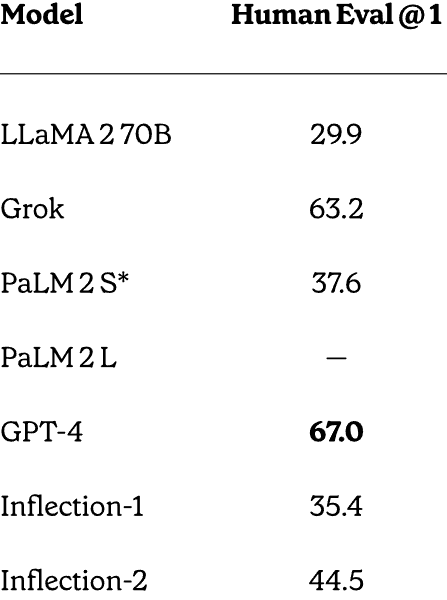

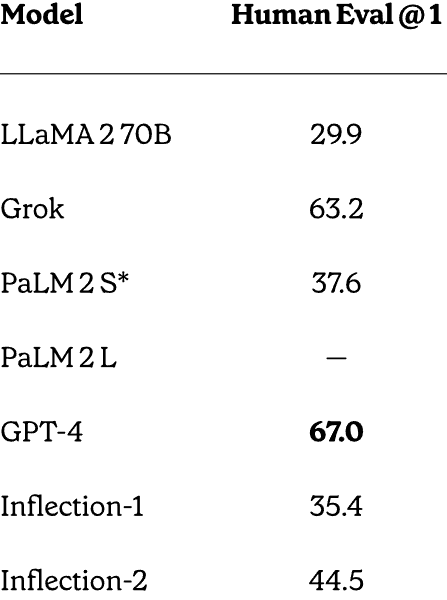

Prueba de conjunto de datos HumanEval

Inflection-2 también superó a PaLM-2 en el conjunto de datos de resolución de problemas HumanEval desarrollado y lanzado por OpenAI.

Hugging Face describe este conjunto de datos:

“El conjunto de datos HumanEval publicado por OpenAI incluye 164 problemas de programación con una firma de función, una cadena de documentación, un cuerpo y varias pruebas unitarias.

Fueron escritos a mano para garantizar que no se incluyan en el conjunto de capacitación de modelos de generación de código.

Los problemas de programación están escritos en Python y contienen texto natural en inglés en comentarios y cadenas de documentación.

El conjunto de datos fue elaborado a mano por ingenieros e investigadores de OpenAI”.

Estas son las puntuaciones:

- LLaMA-2 70B: 29,9

- PaLM-2S: 37,6

- Inflexión-2: 44,5

- GPT-4: 67.0

Como se puede ver arriba, solo GPT-4 obtuvo una puntuación más alta que Inflection-2. Sin embargo, cabe señalar nuevamente que Inflection-2 no fue ajustado para resolver este tipo de problemas, lo que hace que estas puntuaciones sean un logro impresionante.

Captura de pantalla de puntuaciones completas de HumanEval

Inflexión AI explica por qué estas puntuaciones son significativas:

“Resultados en pruebas comparativas de matemáticas y codificación.

Si bien nuestro objetivo principal para Inflection-2 no era optimizar estas capacidades de codificación, vemos un fuerte rendimiento en ambas en nuestro modelo previamente entrenado.

Es posible mejorar aún más las capacidades de codificación de nuestro modelo mediante el ajuste de un conjunto de datos con mucho código”.

Se acerca un LLM aún más poderoso

El anuncio de Inflection AI indicó que Inflection-2 se entrenó en 5000 GPU NVIDIA H100. Están planeando entrenar un modelo aún más grande en un clúster de 22.000 GPU, varios pedidos más grandes que el clúster de 5.000 GPU en el que se entrenó Inflection-2.

Google y OpenAI se enfrentan a una fuerte competencia de empresas emergentes tanto de código abierto como cerradas. Inflection AI se une a los primeros puestos de las startups con una potente IA en desarrollo.

El asistente personal PI es una plataforma de IA conversacional con una tecnología subyacente de última generación con posibilidad de volverse incluso más potente que otras plataformas que cobran por el acceso.

Lea el anuncio oficial:

Inflexión-2: el siguiente paso

Visite el asistente personal de PI en línea

Imagen destacada de Shutterstock/Malchevska