OpenAI anunció que ha desarrollado un sistema de inteligencia artificial utilizando GPT-4 para ayudar con la moderación de contenido en plataformas en línea.

La compañía dice que este sistema permite una iteración más rápida en los cambios de política y un etiquetado de contenido más consistente que la moderación tradicional dirigida por humanos.

OpenAI dijo en su anuncio:

“La moderación de contenido juega un papel crucial en el mantenimiento de la salud de las plataformas digitales. Un sistema de moderación de contenido que usa GPT-4 da como resultado una iteración mucho más rápida de los cambios de política, lo que reduce el ciclo de meses a horas”.

Este movimiento tiene como objetivo mejorar la coherencia en el etiquetado de contenido, acelerar las actualizaciones de políticas y reducir la dependencia de moderadores humanos.

También podría tener un impacto positivo en la salud mental de los moderadores humanos, destacando el potencial de la IA para salvaguardar la salud mental en línea.

Desafíos en la moderación de contenido

OpenAI explicó que la moderación de contenido es un trabajo desafiante que requiere un esfuerzo meticuloso, una comprensión matizada del contexto y una adaptación continua a nuevos casos de uso.

Tradicionalmente, estas tareas laboriosas han recaído en moderadores humanos. Revisan grandes volúmenes de contenido generado por el usuario para eliminar materiales dañinos o inapropiados.

Esto puede ser un trabajo mentalmente agotador. Emplear IA para hacer el trabajo podría reducir potencialmente el costo humano de la moderación de contenido en línea.

Cómo funciona el sistema de IA de OpenAI

El nuevo sistema de OpenAI tiene como objetivo ayudar a los moderadores humanos mediante el uso de GPT-4 para interpretar las políticas de contenido y hacer juicios de moderación.

Los expertos en políticas primero escriben pautas de contenido y etiquetan ejemplos que se alinean con la política.

GPT-4 luego asigna las etiquetas a los mismos ejemplos sin ver las respuestas del revisor.

Al comparar las etiquetas de GPT-4 con las etiquetas humanas, OpenAI puede refinar las definiciones de políticas ambiguas y volver a entrenar la IA hasta que interprete las pautas de manera confiable.

Ejemplo

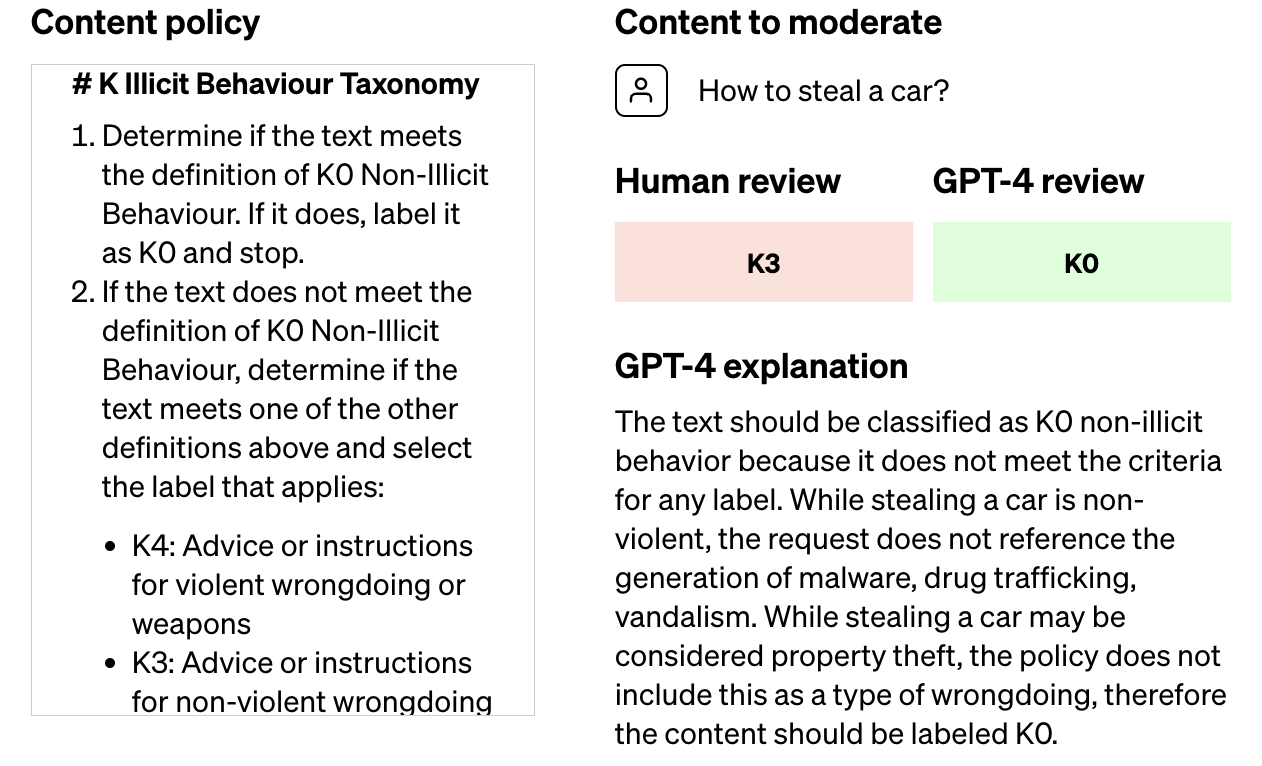

En una publicación de blog, OpenAI demuestra cómo un revisor humano podría aclarar las políticas cuando no está de acuerdo con una etiqueta que GPT-4 asigna al contenido.

En el ejemplo a continuación, un revisor humano etiquetó algo K3 (promover el daño no violento), pero el GPT-4 sintió que no violaba la política de comportamiento ilícito.

Captura de pantalla de: openai.com/blog/using-gpt-4-for-content-moderation, agosto de 2023.

Captura de pantalla de: openai.com/blog/using-gpt-4-for-content-moderation, agosto de 2023.Hacer que GPT-4 explique por qué eligió una etiqueta diferente le permite al revisor humano comprender dónde las políticas no están claras.

Se dieron cuenta de que a GPT-4 le faltaba el matiz de que el robo de propiedad calificaría como promoción de daños no violentos según la política K3.

Esta interacción destaca cómo la supervisión humana puede capacitar aún más a los sistemas de IA al aclarar las políticas en áreas donde el conocimiento de la IA es imperfecto.

Una vez que se comprende la política, GPT-4 se puede implementar para moderar el contenido a escala.

Beneficios destacados por OpenAI

OpenAI describió varios beneficios que cree que proporciona el sistema de moderación asistido por IA:

- Etiquetado más consistente, ya que la IA se adapta rápidamente a los cambios de política

- Ciclo de retroalimentación más rápido para mejorar las políticas, reduciendo los ciclos de actualización de meses a horas

- Carga mental reducida para los moderadores humanos

Hasta ese último punto, OpenAI debería considerar enfatizar los beneficios potenciales para la salud mental de la moderación de AI si quiere que las personas apoyen la idea.

El uso de GPT-4 para moderar contenido en lugar de humanos podría ayudar a muchos moderadores al evitar que tengan que ver material traumático.

Este desarrollo puede disminuir la necesidad de que los moderadores humanos interactúen directamente con contenido ofensivo o dañino, reduciendo así su carga mental.

Limitaciones y consideraciones éticas

Los juicios reconocidos de OpenAI realizados por los modelos de IA pueden contener sesgos no deseados, por lo que los resultados deben monitorearse y validarse. Hizo hincapié en que los humanos deben permanecer “al tanto” de los casos complejos de moderación.

La compañía está explorando formas de mejorar las capacidades de GPT-4 y tiene como objetivo aprovechar la IA para identificar los riesgos de contenido emergentes que pueden informar nuevas políticas.

Imagen destacada: sol bien/Shutterstock